“Si vis pacem, para bellum”: si quieres la paz, prepárate para la guerra, dice un adagio latino. Con el actual avance tecnológico cada vez parece más posible y eficaz delegar en robots de guerra, como los drones, la molesta tarea de eliminar al enemigo; ¿pero se trata de una opción ética y legal?

Human Right Watch ha lanzado una campaña contra el uso de robots con poder letal en los conflictos bélicos, poco antes de que Christof Heyns, relator especial de la ONU sobre ejecuciones extrajudiciales y arbitrarias, presente su informe sobre tales ingenios en la reunión del Consejo de Derechos Humanos que comenzará en Ginebra el próximo 27 de mayo. Se prevé que este informe presentará recomendaciones a los gobiernos para que adopten medidas vinculadas con las armas autómatas.

Repercusiones actuales en el Derecho Internacional

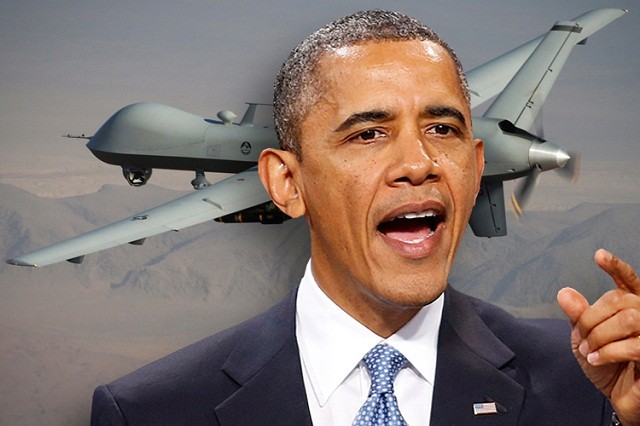

El asunto está suscitando una viva polémica. La Administración Obama ha anunciado recientemente el despliegue en Níger de un centenar de militares para establecer una base de drones o robots de guerra volantes que operarían en el Sahel, con objeto de combatir a grupos armados islamistas.

El IPI’s Global Observatory ha publicado una entrevista a una profesora de la Universidad de Notre Dame (EE.UU.), Mary Ellen O’Connell, quien presidió el Comité sobre el uso de la fuerza en la Asociación Internacional de Derecho entre 2005 y 2010, y fue vicepresidenta de la Sociedad Americana de Derecho Internacional. Para O’Connell, las actuaciones de EE.UU. con sus drones están inventando unas “nuevas reglas bélicas” que atentan contra las normas de guerra internacionalmente aceptadas. Concretamente, los ataques con drones en países como Yemen y Pakistán no respetan las condiciones fijadas en la Carta de la ONU para el uso de la fuerza militar: no se ha producido un conflicto bélico en los términos establecidos en el art. 51, ni el Consejo de Seguridad ha autorizado la intervención, ni ningún país ha solicitado ayuda a EE.UU., como Afganistán hizo en su día.

En un declaración ante una comisión parlamentaria nortemaricana en abril de 2010, O’Connell afirma que las operaciones antiterroristas con drones norteamericanos en Pakistán fueron contraproducentes, y han dado lugar a un gran número de muertes. Según David Kilcullen, experto en terrorismo, tales ofensivas están fomentando “un sentimiento de ira que une a la población con los grupos extremistas”. En cambio, se ha constatado que Al Qaeda pierde apoyos en el mundo musulmán debido a sus tácticas violentas.

La cuestión cobra cada vez mayor relevancia, pues también otros países, como Israel, China, India o Rusia, se han sumado a la carrera armamentística de los drones.

Robots de guerra futuros y derechos humanos

Hace unos meses, Human Rights Watch (HRW) y la International Human Rights Clinic (IHRC), de la Facultad de Derecho de Harvard, publicaron un informe de 50 páginas para alertar sobre los problemas jurídicos, éticos, y humanitarios que plantean estas armas. Algunos expertos militares y de robótica han pronosticado que los robots militares completamente autónomos, que pueden seleccionar y atacar objetivos sin intervención humana, podrían estar disponibles dentro de 20 o 30 años.

El informe considera que tales armas no serían compatibles con el derecho internacional humanitario. La principal preocupación de Human Rights Watch y la IHRC es el impacto que las armas totalmente autónomas tendrían sobre la protección de civiles en tiempos de guerra. Por eso solicitan una prohibición preventiva de su uso y desarrollo, mediante un tratado internacional vinculante. También recomiendan establecer un código de conducta para la investigación en robots militares, a fin de que en todas las etapas del su desarrollo tecnológico se tengan en cuenta las consideraciones éticas y legales acerca de su uso en conflictos armados.

En reconocimiento de los problemas que podrían generar estas armas, el Departamento de Defensa de EE.UU. promulgó el año pasado una directiva que exige que un humano esté “al tanto” de las decisiones que impliquen el uso de fuerza letal. A la vez, se autoriza a desarrollar o utilizar únicamente sistemas completamente autónomos si no aplican la fuerza letal. Si bien es una medida positiva, la directiva no ofrece una solución integral ni permanente a los problemas que implican los sistemas totalmente autónomos, según el informe de HRW y la IHRC.

Estos robots tienen sus defensores, y también por motivos humanitarios. John McGinnis, profesor de derecho de la Universidad Northwestern, sostiene que tales robots en el campo de batalla “pueden conducir a una menor destrucción, convirtiéndose en una fuerza civilizadora en las guerras, así como en una ayuda a la civilización en su lucha contra el terrorismo”. Para que los robots puedan en efecto “decidir” en cada caso con acierto, Ronald Arkin, experto en robótica en el Instituto de Tecnología de Georgia, propone crear un sofisticado programa, “gobernador ético”, que los dotaría de los códigos adecuados para determinar si usa o no la fuerza mortífera.

Si eso realmente llega a realizarse algún día, de todas formas no resuelve el problema sino lo traslada. La responsabilidad será de quienes definan los criterios de funcionamiento de los robots, que no matarán con furia sanguinaria ni se entregarán al pillaje, pero actuarán según como los hayan programado.

// OTROS TEMAS QUE TE PUEDEN INTERESAR